Der Microsoft SQL Server 2014 ist seit Anfang April verfügbar. Das deutsche Launch Event für die neue Datenbank-Generation richtet Microsoft am 13. und 14. Mai aus. Was der SQL Server jetzt besser kann, und worauf IT-Verantwortliche bei der Lizenzierung achten müssen, zeigt der Microsoft-Spezialist Avispador schon heute auf.

Von Axel Oppermann aus dem MSFTbriefing von Avispador & techconsult

Das Management von Datenbanklösungen wie dem SQL-Server von Microsoft gehört zum Tagesgeschäft der IT-Abteilungen. Insbesondere Microsoft konnte seinen Produkten in den letzten Jahren eine gewisse Relevanz verleihen. Dies sorgte für ein überdurchschnittliches Wachstum und umfassende, teils unternehmenskritische, Anwendungsszenarien.

Dennoch muss die Auseinandersetzung mit der neuen Generation des MS SQL Servers auf eine andere Art und Weise erfolgen. Bedingt wird dies einerseits durch die tiefere Integration in andere Microsoft-Produkte, andererseits durch die umfassenden neuen Möglichkeiten für Anwender und dem neuen Verständnis für Datenanalyse – beziehungsweise Datennutzung – im Unternehmen.

Datenbankstrategie bedarf der Analyse

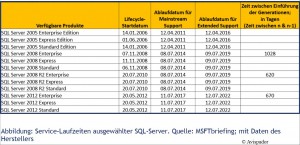

Unternehmen, die noch verstärkt auf den SQL Server 2005 setzen, dessen Extended-Support am 12.04.2016 endet, sowie Organisationen, die umfassend den SQL Server 2008 einsetzen, dessen Mainstream-Support am 8.7.2014 endet, müssen sich zwingend mit ihren Datenbank- beziehungsweise. Rechenzentrumstrategien beschäftigen. Hier gilt es insbesondere die Vor- und Nachteile der SQL-Server-Generationen 2012 und 2014 zu vergleichen und die neuen Funktionen zu bewerten, beziehungsweise eine Roadmap für die Adaption und umfassende Einführung zu erarbeiten.

Integrierte In-Memory-Technik

Eine der wichtigsten Neuerungen im neune Release bildet die integrierte In-Memory-Technik “Online Transaction Processing” (OLTP). Hierbei handelt es sich quasi um einen Turbolader für die Geschwindigkeit. Nach Angaben von Microsoft soll die Leistung um das 30-Fache beschleunigt werden. Das In-Memory OLTP ist eine Erweiterung bereits bestehender In-Memory-Funktionen in den Bereichen für Data-Warehousing und Business-Intelligence des SQL-Servers. Andere Anbieter, wie SAP mit HANA oder IBM mit der DB2, haben bereits vergleichbare In-Memory-Produkte oder -Fähigkeiten im Angebot.

Neben Performance bringt die neueste Datenbankgeneration insbesondere Funktionen in den Bereichen Big Data und Polystrukturierte Daten. Der Begriff Polystrukturierte Daten beschreibt unstrukturierte und strukturierte Daten sowie maschinengenerierte Daten wie exemplarisch Web-Logs oder Sensordaten.

Der neue SQL-Server hat einen noch stärkeren Anschluss an die Cloud als seine Vorgänger. Ein Ziel ist es, die Einführung von Clouds für SQL-Datenbanken zu vereinfachen und hybride Szenarien zu unterstützen. Der neue Server lässt sich wahlweise für On-Premise, reine Azure-Anwendungen oder für Hybrid-Cloud-Lösungen nutzen.

Microsoft Neuausrichtung in Strategie einbeziehen

Wenn Microsoft gegenwärtig neue Produkte einführt, sind diese nicht alleine zu betrachten; sie sind nicht als reine Software zu verstehen. Vielmehr müssen Produkte, deren Lizenzierung und insbesondere Funktionen immer im Kontext der gegenwärtig exekutierten Neuausrichtung zu einem Anbieter von „Service und Devices“ gesehen werden. Damit einher geht die Reorganisation des Unternehmens. Das Ziel ist ein funktionsorientiertes beziehungsweise funktionsgesteuertes Unternehmen – im Gegensatz zur bisherigen produktorientierten Organisation.

Einher mit allen Tätigkeiten geht gegenwärtig die umfassende Entwicklung in Richtung Cloud. Ein Ziel ist es, eine konsistente Plattform anzubieten, die sowohl beim Anwenderunternehmen, bei Serviceprovidern oder unter der Cloud-Plattform Microsoft Azure läuft. Hierzu hat Microsoft seine Produkte über Jahre hinweg weiterentwickelt. Als Grundlage für die Cloud dient hierbei Azure und der Windows Server (2012 R2). Die Plattform besteht darüber hinaus aus Lösungen wie System Center (2012 R2), Intune, Visual Studio, dem .NET-Framework und natürlich dem SQL Server 2014. Microsoft fasst diese Strategie unter dem Begriff Cloud OS zusammen.

Cloud OS als konsistentes Managementwerkzeug

Cloud OS von Microsoft ist ein konsistentes Managementwerkzeug, das als einheitliche und zentrale Lösung die Verwaltung von Endgeräten ermöglichen soll. Es werden Features bereitgestellt, die eine Prozessautomatisierung abbilden. Automatische Reaktionen auf Laständerungen werden genauso möglich wie das Management heterogener Systeme über Cloud-Grenzen hinweg. Darüber hinaus wird die Verarbeitung und Analyse einer Vielzahl unterschiedlicher Inhalte aus unterschiedlichen Quellen ermöglicht und die Transformation von Daten, über Information bis hin zu Wissen arrangiert. Diese Daten können über Applikationen individuell für jedermann bereitgestellt werden.

Gerade dieser Ansatz, Daten und Informationen umfassend den Anwendern, also Kunden, Partnern und Mitarbeitern, bereitzustellen, kommt den gegenwärtigen und zukünftigen Anforderungen der Anwenderunternehmen besonders nahe. Hierdurch werden völlig neue Geschäftsmodelle oder Arbeitsabläufe ermöglicht.

Einige Szenarien sind hier so aufgebaut, dass der SQL-Server das Backend abbildet. Dem Anwender bekannte und vertraute Lösungen wie Excel oder SharePoint bilden das Frontend. Diese werden durch Self-Service-Business-Intelligence-Dienste wie Power BI erweitert oder abgerundet. Bei genauerer Analyse ist zu erkennen, dass Microsoft hier genau die Anforderungen von Unternehmen und Anwendern trifft, die ihr Geschäftsmodell bzw. den Arbeitsalltag durch verlässliche, verfügbare und modellierbare Daten aufbauen.

Austausch- und Abhängigkeitsverhältnisse steigen

Es ist aber auch zu erkennen, dass zur Nutzung dieser Funktionen eine Vielzahl unterschiedlicher, immer aktueller, Microsoft-Produkte notwendig ist. Also nicht nur die Möglichkeiten, sondern vielmehr die Austausch- und Abhängigkeitsverhältnisse werden immer größer.

Dies muss bei der strategischen Betrachtung des Lieferanten Microsoft berücksichtigt werden. Es muss klar sein, dass die Betrachtung einzelner Produkte immer weniger zielführend sein wird. Nutzen und realer Mehrwert entsteht immer häufiger erst durch die Kombination von unterschiedlichen Produkten.

Diese Tendenz ist im Bereich Office schon länger sichtbar. Hierzu ein Beispiel: So ist das Suchen von Exchange-Inhalten über das eDiscovery-Center in SharePoint 2013 eine wertvolle Funktion, die es ermöglicht, über eine Verbundsuche (entsprechende API-) Exchange-Postfachinhalte sichtbar zu machen.

Was wie geschildert im Office-Umfeld seit langer Zeit erkenntlich ist, wird nun auch immer deutlicher, wenn es um den Bereich Server & Tools (Azure, Windows Server, SQL, System Center) geht. Aber auch Abhängigkeiten zwischen Backend-Lösungen wie dem SQL-Server und Frontend-Anwendungen wie Excel erhöhen sich.

Bei Vorbereitungen auf Verhandlungen für neue Volumenverträge oder Renewals müssen diese Verbundeffekte berücksichtigt werden. Einerseits dürfen wichtige Funktionen und Arbeitsweisen für Fachbereiche nicht verbaut werden; andererseits gilt es, die Verträge den aktuellen und zukünftigen Nutzungsgewohnheiten anzupassen.

Höherer Migrationsdruck

Neben der zunehmenden Integration der einzelnen Produkte ist eine weitere relevante Tendenz zu erkennen: Die Gestaltung der Produkte ist ein klares Kennzeichen für die Forcierung des Cloud-Geschäfts von Microsoft und bildet eine Grundlage für zukünftige Entwicklungen. Für Anwenderunternehmen bedeutet diese Entwicklung, dass das umfassende Leistungspotenzial einzelner Produkte zukünftig, und dabei wesentlich umfassender als in der Vergangenheit, nur im Verbund mit Cloud-Systemen/-Komponenten angehoben werden kann.

Hierdurch entsteht neben der Bindung an den Lieferanten Microsoft regelmäßig ein höherer Migrationsdruck und in Summe höhere Ausgaben. Es kann davon ausgegangen werden, dass zukünftig die Preisbildung nicht nur überwiegend von den Komponenten „Leistungsfähigkeit des einzelnen Produktes“ und „Marktumfeld“ abhängt, sondern vielmehr auch auf Basis der Leistungsfähigkeit der gesamten Plattform ermittelt wird.

Bereits heute hat Microsoft bedingt durch die eigene Historie und durch die aktuelle Strategie gegenüber den Wettbewerbern einen (zeitlichen) Vorteil. Der von Microsoft forcierte ganzheitliche Ansatz sorgt dafür, dass ein nahtloses Angebot für den Einsatz von Software und Services offeriert werden kann. Dies reicht vom eigenen Rechenzentrum des Anwenderunternehmens, über Services von Hosting-Providern bis hin zu den Microsoft-Cloud-Services.

Trotz unterschiedlicher Bemühungen sieht es gegenwärtig weder danach aus, dass es die großen Cloud-Anbieter wie AWS (Amazon) in das Unternehmensrechenzentrum zieht, noch dass Größen im Rechenzentrum – wie etwa VMware – schnell umfassende beziehungsweise vergleichbare eigene Cloud-Rechenzentren aufbauen werden. Durch diese Ist-Situation hat Microsoft einen Vorteil gegenüber anderen Anbietern, welcher monetarisiert werden kann. Sowohl IT-Entscheider als auch Strategen in Anwenderunternehmen sollten sich dieser Situation gewahr werden.

SQL-Server haben ein Ablaufdatum

Blicken wir zurück in das Jahr 2004. Seinerzeit waren im Microsoft-Universum der Windows Server 2003 R2 und SQL 2000 up to date. Datenbanken mit 300 GB galten als groß, als Hauptprozessoren wurden regelmäßig Single-Core-CPUs eingesetzt. Die Datenbanken griffen auf ein RAM von in der Regel 4 bis 8 GB zurück. Abfragen und Analysen blockierten oft lange IT-Ressourcen und brachten die Kapazitäten an ihre Grenzen. Die gewonnenen Daten wurden nur wenigen Mitarbeitern zur Verfügung gestellt.

Machen wir nun einen kleinen zeitlichen Sprung in die Gegenwart und blicken dabei in die Zukunft: Aktuell stehen in einer Microsoft-basierten Unternehmens-IT Windows Server 2012 sowie die SQL Server 2008 und 2012 hoch im Kurs. Multi-Core-Prozessoren und Systeme mit einem RAM von über 32 GB (und bis hin zu 2 TB) sind die Regel. Datenbestände mit einem Volumen von über 1 TB sind keine Seltenheit.

Die geänderte Art der Nutzung im Unternehmen ist neben der technischen Entwicklung ein besonders wichtiger Aspekt. Immer mehr Mitarbeiter bekommen Zugriff auf Self-Service-Business-Intelligence-Dienste oder ausgewertete Daten. Diese Informationen werden den Anwendern, egal ob Kunde, Partner oder Mitarbeiter, auf den von ihm gewünschten Endgeräten bereitgestellt.Immer mehr Unternehmen setzen bei ihren Planungen für die Ausrichtung ihres Unternehmens und die Gestaltung von Arbeitsprozessen auf Daten, Informationen und das daraus entstehende Wissen.

Gerade Unternehmen die in einem Wirtschaftsumfeld wie Deutschland beheimatet sind, das in der Regel als hochpreisiger Standort gilt, können in direkten und indirekten Wettbewerbssituationen mit anderen Unternehmen durch den Einsatz von Datenanalysen – respektive der umfassenden Nutzung von Daten – Wettbewerbsvorteile erzielen. Dies sind gegenwärtig insbesondere Daten über das Verhalten von Kunden und Wettbewerbern; zukünftig stärker von Produktionsprozessen und einzelnen Objekten. Um diese Vorteile zu nutzen, müssen moderne – bzw. zukunftsfähige – IT-Systeme eingesetzt werden.

Altsysteme erschließen BI-Potenzial nicht

Datenbank-Lösungen wie der SQL Server 2005, der teilweise noch verbreitet und bis 2016 supportet wird, können diesen Anforderungen nicht gerecht werden. Auch die zukunftsweisenden Einsatzszenarien für Produkte wie den SQL Server 2008 werden immer geringer. Dies hängt auch damit zusammen, dass diese Generationen in Zeiten entwickelt wurden, in denen aktuelle Einsatzszenarien wie In-Memory-Analysen oder kundenzentrierte Self-Service-Modelle noch weit entfernt waren. Diese Generationen können noch gut für isolierte- oder teilisolierte Umgebungen genutzt werden. Zukunftsweisende Modelle, ob mit oder ohne Microsoft-Technologie, benötigen moderne, integrierte Systeme.

Support-Laufzeiten bilden Sollbruchstelle

Microsoft bietet regelmäßig Support für Unternehmensprodukte für einen Zeitraum von 10 Jahren an. Dabei wird ein Mainstream-Support für Unternehmensprodukte für 5 Jahre oder für einen Zeitraum von 2 Jahren ab Freigabe des Nachfolgeprodukts (N+1) garantiert, je nachdem, welcher Zeitraum länger ist.

Darüber hinaus wird ein Extended-Support für die auf den Mainstream-Support folgenden 5 Jahre bzw. für einen Zeitraum von 2 Jahren ab Freigabe des zweiten Nachfolgeprodukts (N+2) angeboten. Auch hier gilt die entsprechende Regel je nachdem, welcher Zeitraum länger ist.

Geänderte Lizenzierungsbedingen beachten

Mit dem SQL Server 2014 setzt Microsoft klaren Kurs auf die weitere Entwicklung der Datenbanklösung. Die Produkte entwickeln sich deutlich in Richtung Cloud, Cloud-Koexistenz und Performance. Der Betrieb in unternehmenskritischen Umgebungen wurde nicht nur verbessert, sondern bildet ein zentrales Element der Weiterentwicklung. Dies untermauern insbesondere die neuen oder erweiterten Funktionen wie Workload-übergreifendes In-Memory, Skalierbarkeit, die Möglichkeiten hybrider Cloud-Szenarien oder Cloud BI.

Mit dem SQL Server 2014 setzt Microsoft klaren Kurs auf die weitere Entwicklung der Datenbanklösung. Die Produkte entwickeln sich deutlich in Richtung Cloud, Cloud-Koexistenz und Performance. Der Betrieb in unternehmenskritischen Umgebungen wurde nicht nur verbessert, sondern bildet ein zentrales Element der Weiterentwicklung. Dies untermauern insbesondere die neuen oder erweiterten Funktionen wie Workload-übergreifendes In-Memory, Skalierbarkeit, die Möglichkeiten hybrider Cloud-Szenarien oder Cloud BI.

Der SQL Server 2014 als Bestandteil der übergeordneten Cloud-OS-Strategie ermöglicht es, in Lösungen und nicht mehr nur in Anwendungen zu denken. Diese Lösungen müssen vom Anwender im Rechenzentrum aus, und nicht umgekehrt wie bisher, gedacht werden.

Doch die schöne neue Welt hat auch Haken: Selbst wenn ein höherer/besserer ROI erzielt werden kann, bedeutet eine Ausrichtung auf die neue Generation zusätzliche Kosten. Diese entstehen nicht nur direkt durch die Lizenzkosten für das eigentliche Produkt, vielmehr erzeugt der Lösungsgedanke, wie oben skizziert, Austauschverhältnisse und zusätzliche Kosten.

Unternehmen, die noch überwiegend auf SQL 2005 und 2008 setzen, sollten sich umgehend und umfassend mit einem Vergleich der aktuellen Generationen 2012 und 2014 beschäftigen. Neben einem Funktionsvergleich gilt es insbesondere, die im Unternehmen gewünschten sowie realisierbaren Einsatzgebiete (Use Cases) zu ermitteln. Eine perspektivische Planung, bezogen auf das RZ inklusive Windows Server sowie die Anwenderwerkzeuge, wie Customer-Relationship-Management (CRM)- oder Office-Lösungen, ist das Gebot der Stunde.

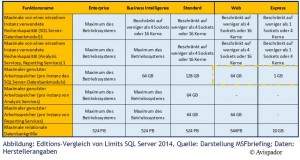

Diese Unternehmen müssen sich auch mit den im Vergleich zu den Generationen 2005 und 2008 geänderten Lizenzierungsbedingen beschäftigen. So erfolgte mit der Markteinführung des SQL Server 2012 eine Änderung der Lizenzierung bezogen sowohl auf Rechenleistung (Core-based) als auch auf Anwender bzw. Geräte (Server+ CAL).

Core-Lizenzierung pro Prozessor erfordert Workload-Analyse

Mit dieser Form der Lizenzierung ging Microsoft beim SQL-Server einen neuen Weg. Die bis dato etablierte Prozessorlizenzierung wurde durch eine Core-Lizenzierung pro Prozessor ersetzt. Hierbei gilt es zu beachten, dass ein Minimum von vier Cores pro Prozessor zu lizenzieren ist – dies in zwei Core-Inkrementen (also in schrittweiser Erhöhung à zwei Cores). Bevor eine Umstellung realisiert wird, gilt es genau die einzelnen Workloads zu analysieren und auf Basis der Workloads die entsprechenden Editionen auszuwählen.

Aber auch der Zusammenhang zwischen Betriebsform und Lizenzierung sind bei einer Migration von 2005/2008 auf 2012/2014 zu beachten, insbesondere wenn die Server in virtualisierten Umgebungen laufen. Soll zum Beispiel eine virtuelle SQL-Server-2012-Maschine per Core lizenziert werden, müssen alle virtuellen Cores lizenziert werden – minimal vier Cores pro virtueller CPU; soll eine virtuelle SQL-Server-2012-Maschine pro CAL lizenziert werden, muss ein Server pro virtueller Maschine lizenziert werden.

Self-Service-Business-Intelligence

Nicht jedem IT-Verantwortlichen oder Administrator gefällt der Gedanke, dass sie Anwender bei der Nutzung von Self-Service-Business-Intelligence–Diensten unterstützen sollen. Zu schwer wiegt noch das Access-Trauma, welches einen unkontrollierten Wust von Datenbank und dezentralen Datenbeständen mit teilweise prozesskritischer Bedeutung hervorbrachte. Noch heute werfen sich regelmäßig Anwender vor den PC, wenn ihnen die Access-Datenbank genommen werden soll.

Für IT-Professionals gibt es eine gute und eine schlechte Nachricht: Die schlechte Nachricht lautet, dass sie nicht um eine Unterstützung herumkommen werden. Anwender erwarten einen praktischen und unkomplizierten Zugriff auf Daten und Informationen von nahezu jedem Ort und jedem beliebigen Gerät aus.

Hinzu kommt der Marketingdruck der Anbieter. Was für den Anwender oder Fachabteilungsleiter schnell und einfach formuliert ist, stellt die IT-Administratoren teilweise vor erhebliche Herausforderungen. Insbesondere dann, wenn im Unternehmen oftmals noch alte IT-Infrastrukturen vorherrschen. Auch sträuben sich bei so manchem IT-Professional (IT-Pro) die Nackenhaare, wenn sie die von den Fachbereichen gestellten Anforderungen hinsichtlich der Einhaltung von Sicherheitsvorgaben validieren und abbilden sollen.

Anwendungsszenarien bei der Planung beachten

Die gute Nachricht lautet, dass bei der richtigen Herangehensweise von IT-Leitern, die IT-Abteilung weiterhin Herrscherin über die Daten bleibt, und so die Interessen des Unternehmens und der Anwender nachhaltig schützen bzw. erfüllen kann. Um diese wichtige Datenhoheit sicherzustellen, und so Daten zu schützen und die Qualität zu steigern, müssen bereits bei der Planung einer SQL-Server-(2014)-Umgebung etwaige Anwendungsszenarien beachtet werden.

Die Bereitstellung kann über integrierte Self-Service-Business-Intelligence-Dienste abgebildet werden oder durch spezifische Apps. Dabei ist der App-Ansatz in mehrfacher Hinsicht charmant. Das Management der Daten wird vereinfacht und das Deployment zum Anwender erleichtert. Um solche Apps zu erstellen bzw. bereitzustellen, kommen, bezogen auf die Microsoft-Welt, die weiteren Komponenten der Cloud-OS-Werkzeugkiste zum Tragen. Cloud OS ermöglicht die Etablierung von „Modern Apps“.

Allerdings wird die Lizenzierung – respektive der Einsatz – eines breiten Spektrums an Microsoft-Produkten notwendig. Die „Modern Apps“ orientieren sich an den Bedürfnissen der Anwender und interagieren mit anderen Anwendungen; dabei kann auf eine Vielzahl von Datenquellen zurückgegriffen werden. Diese Form von Anwendungen zeichnen sich durch hohe Anpassbarkeit aus. Das Deployment kann durch unternehmenseigene App-Stores erfolgen. Zugriffsrechte werden über Identitätsmanagement-Lösungen geklärt. Axel Oppermann/hei

Anzeige

is report Business Intelligence Guide 2013

Bestellen können Sie diese Standardreferenz für den BI-Markt telefonisch unter 089/90 48 62 10 und per E-Mail unter eantritter@isreport.de